会议软件Zoom也来搞AI了,称在AI最难考试上“击败”了Gemini 3

会议软件Zoom也来搞AI了,称在AI最难考试上“击败”了Gemini 3最近,视频会议软件公司 Zoom 发布了一条出人意料的消息:他们宣称在“人类最后的考试”(Humanity s Last Exam,简称 HLE)这个号称当前 AI 领域最具挑战性的基准测试上,取得了 48.1% 的成绩,比此前由 Google Gemini 3 Pro(带工具)保持的 45.8% 高出 2.3 个百分点。

最近,视频会议软件公司 Zoom 发布了一条出人意料的消息:他们宣称在“人类最后的考试”(Humanity s Last Exam,简称 HLE)这个号称当前 AI 领域最具挑战性的基准测试上,取得了 48.1% 的成绩,比此前由 Google Gemini 3 Pro(带工具)保持的 45.8% 高出 2.3 个百分点。

Claude最近推出了一个令人兴奋的特性——Skills系统。它让AI Agent能够动态加载专业能力,按需”学习”处理PDF、Excel、PPT等专业文档的技能。作为一个开源爱好者,我立刻意识到这个设计的价值,并在Minion框架中实现了完整的开源版本。本文将介绍Skills的设计理念,以及我的开源实现细节。

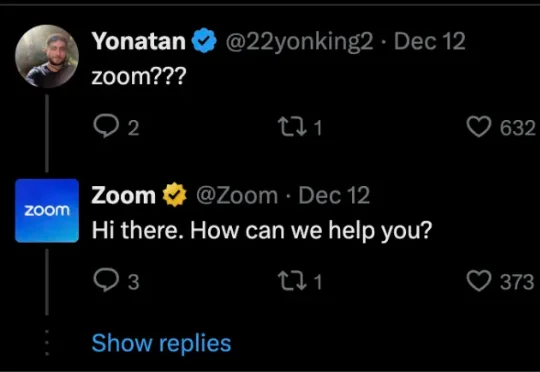

你是否也觉得,AI 配音的语调总是差了那么点 “人情味”?它能把台词念得字正腔圆,口型分秒不差,但角色的喜怒哀乐却总是难以触及灵魂深处。

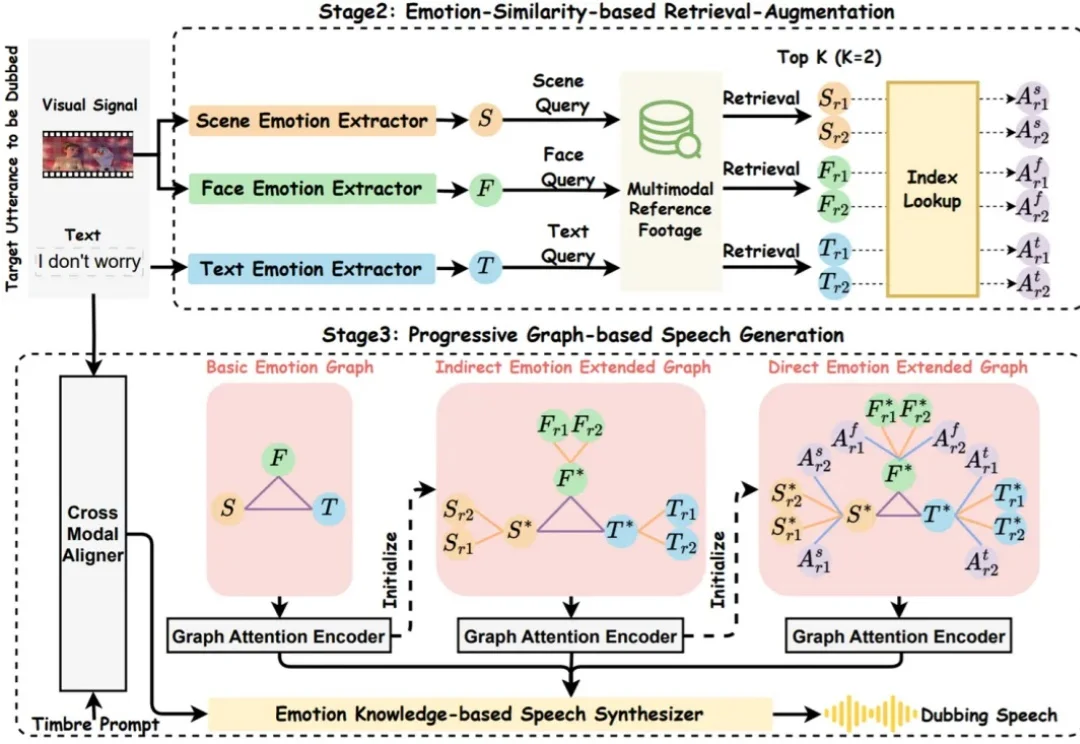

近日,24 岁的 00 后博士生胡文博和所在团队造出一款名为 G²VLM 的超级 AI 模型,它是一位拥有空间超能力的视觉语言小能手,不仅能从普通的平面图片中精准地重建出三维世界,还能像人类一样进行复杂的空间思考和空间推理。

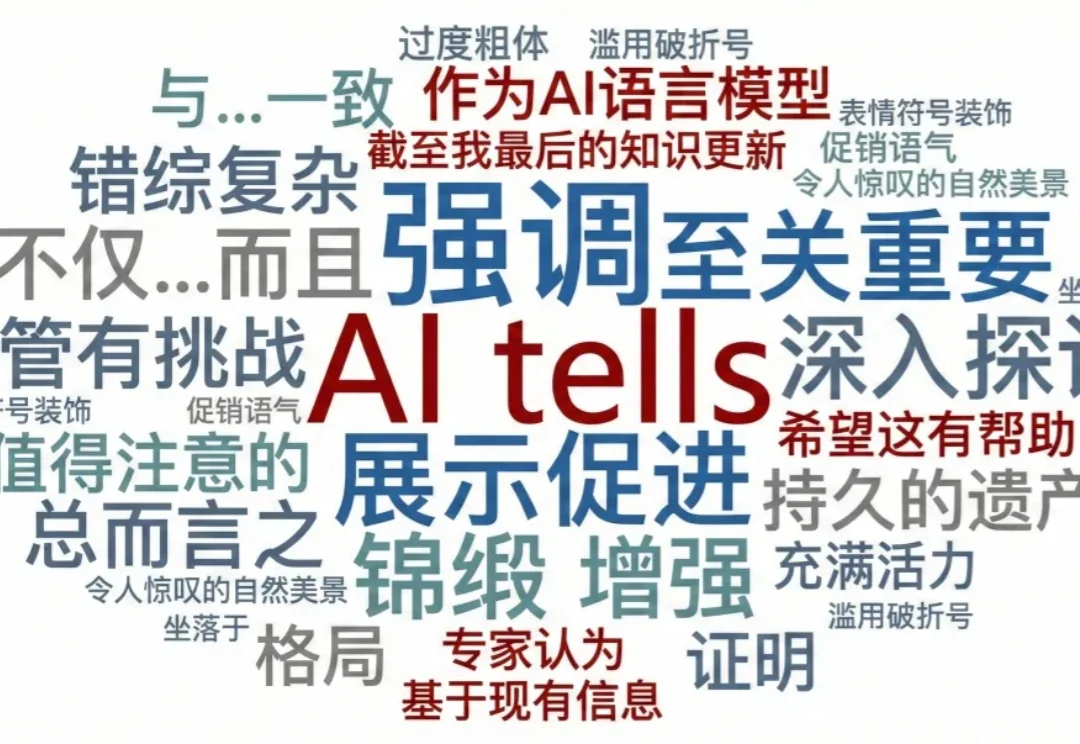

「这是一项革命性的工作」、「不是……而是……」、「首先……其次……」;在一篇文章里读到这些词,你是不是本能地开始觉得,有点不对劲了。

现在的大学生该选什么专业?未来一百年的大学会是什么样子?业界 AI 如此强势,学界还能做什么?谷歌在过去二十多年里做对了什么,又有哪些遗憾?

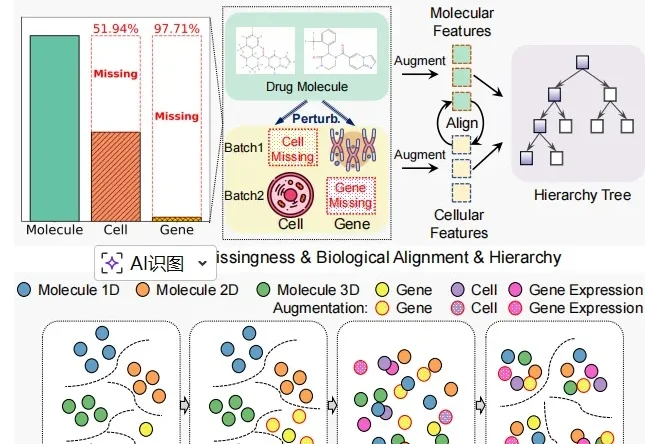

近日,中山大学博士生李孟燃和中国科学院香港创新研究院臧泽林博士及合作者打造出一种名为 CHMR 的 AI 系统,堪比一位拥有细胞之眼的 AI 化学家,能让药物研发变得更精准和更安全。

多语言大模型(MLLM)在面对多语言任务时,往往面临一个选择难题:是用原来的语言直接回答,还是翻译成高资源语言去推理?

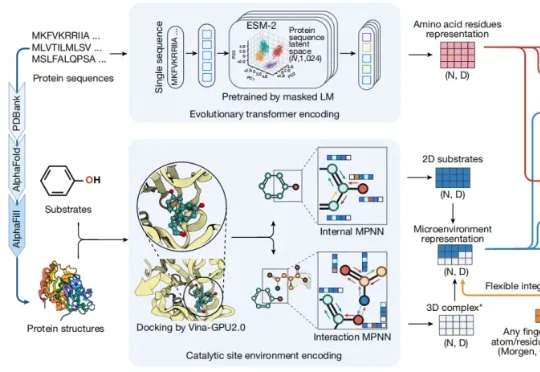

近日,由美国伊利诺伊大学厄巴纳香槟分校 Huimin Zhao 教授和南京师范大学教授崔海洋等人共同研发出一种名为 EZSpecificity 的 AI 工具,成功给酶装上了智能识别系统,能以前所未有的准确度预测酶和底物之间的匹配关系,相关论文发表于 Nature。

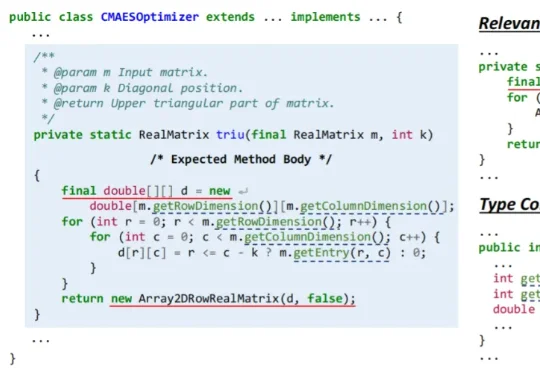

近日,浙江大学副教授胡星和团队开发出一款名为 CatCoder 的 AI 框架,它能够读懂一个完整的软件项目,生成准确、可用的代码。在 Java 任务上,它在代码编译通过率和测试通过率上,比业内表现突出的代表之一 RepoCoder 最高提升了 14.44% 和 17.35%。